L'esperimento è semplice: carichiamo una nostra foto su ChatGPT e inseriamo un "prompt", ovvero un'istruzione, per generare l'immagine desiderata. Sembra che il segreto per ottenere buoni risultati stia proprio nel prompt. Sorprendentemente, lo stesso prompt funziona perfettamente in inglese, ma viene rifiutato in italiano. Create image. Create a toy of the person in the photo. Let it be an action figure. Around the figure, there should be the toy’s equipment, each in its individual blisters.

La descrizione del contenuto di questa scatola può essere fatta a piacere, inserendo ciò che più si desidera, in modo che sia attinente ai nostri gusti o passioni.

Perché questa differenza tra inglese e italiano? ChatGPT spiega che non è una questione di lingua, ma di interpretazione. In inglese, il sistema presume che si stia creando una figura ispirata alla persona nella foto, non una rappresentazione diretta. In italiano, invece, è molto più rigido e teme violazioni delle politiche sui contenuti, legate all'identità e al consenso implicito. Questa reazione di ChatGPT ci porta a riflettere su come l'IA interpreti e reagisca a input diversi.

Ci dimostra anche come sia fondamentale calibrare attentamente i prompt, soprattutto in lingue diverse dall'inglese. E ci ricorda che, per quanto sofisticata, l'intelligenza artificiale ha ancora bisogno della scintilla umana per creare qualcosa di veramente originale e significativo.

In sostanza, l'esperimento con ChatGPT si rivela un interessante spaccato sulle dinamiche dell'IA, sulle sue interpretazioni e sui limiti che ancora presenta. E ci invita a considerare il ruolo dell'umano nel guidare e plasmare queste tecnologie.

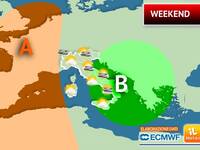

Meteo, Weekend dal doppio volto: prima il Sole, poi Domenica peggiora, i dettagli

Meteo, Weekend dal doppio volto: prima il Sole, poi Domenica peggiora, i dettagli Allerta Meteo, avviso della Protezione Civile: tra poco Temporali e Grandinate, regioni a rischio

Allerta Meteo, avviso della Protezione Civile: tra poco Temporali e Grandinate, regioni a rischio Meteo: Prossima Settimana, entro il Primo Maggio cambia tutto! Gli aggiornamenti

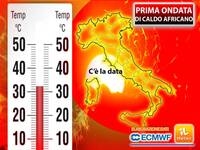

Meteo: Prossima Settimana, entro il Primo Maggio cambia tutto! Gli aggiornamenti  Meteo: Caldo a 30°C tutto d'un colpo. Ecco quando

Meteo: Caldo a 30°C tutto d'un colpo. Ecco quando Meteo: Grandinata pazzesca in Puglia, oltre 20 cm di ghiaccio e auto bloccate; il Video

Meteo: Grandinata pazzesca in Puglia, oltre 20 cm di ghiaccio e auto bloccate; il Video Meteo Maggio: l'Estate sfonda le porte in anticipo, ecco quanto farà Caldo

Meteo Maggio: l'Estate sfonda le porte in anticipo, ecco quanto farà Caldo Meteo: fine Aprile con l'ombrello, ma ad inizio Maggio cambia tutto! Le parole ufficiali di Antonio Sanò

Meteo: fine Aprile con l'ombrello, ma ad inizio Maggio cambia tutto! Le parole ufficiali di Antonio Sanò